Stap even in de wereld van kunstmatige intelligentie. Stel je voor: je typt een vraag in ChatGPT of Gemini en nog voordat je een slokje van je koffie hebt genomen, verschijnt er een welbespraakt, contextrijk antwoord op je scherm. Maar heb je je ooit afgevraagd hoe dat in vredesnaam gebeurt? Wat gebeurt er achter dat digitale gordijn om AI (bijna) net als wij te laten praten?

Het is het snijvlak van enorme hoeveelheden data, neurale storytelling en het genie van menselijke innovatie. Vandaag gaan we achter de schermen kijken om te ontrafelen hoe Large Language Models (LLM’s) hun antwoorden genereren. Geloof me, aan het einde zul je AI in een heel nieuw licht zien.

Patronen boven geheugen: het echte geheim achter LLM-intelligentie

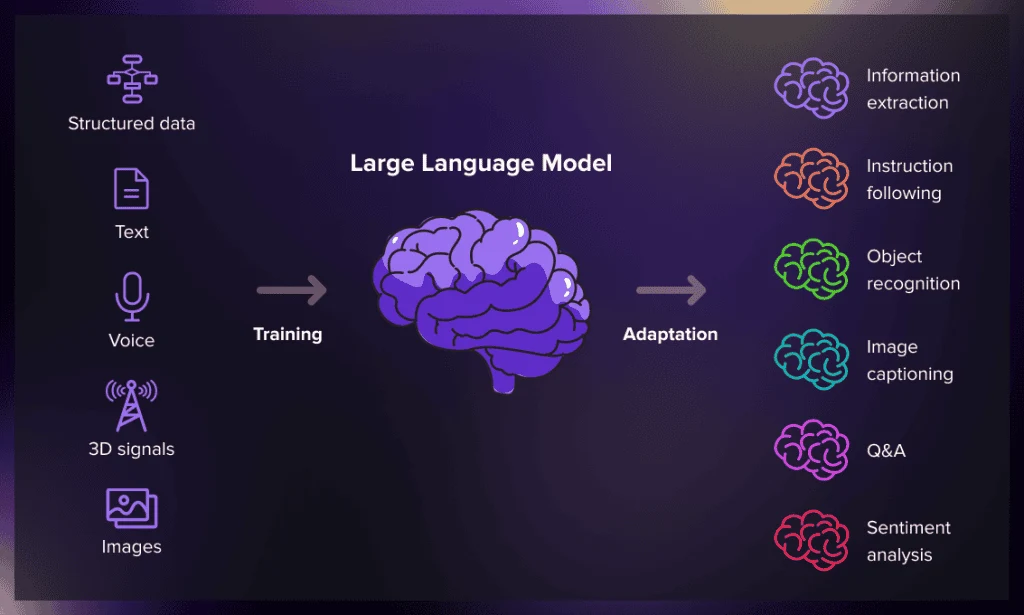

Laten we eenvoudig beginnen. Een LLM of Large Language Model is in wezen een stuk geavanceerde software dat is getraind op enorme hoeveelheden tekst: boeken, tijdschriften, webpagina’s, gesprekken, coderepositories en meer. Maar in plaats van informatie uit het hoofd te leren zoals een papegaai, leren LLM’s patronen die diep in de taal zelf verborgen liggen.

Ze bestuderen hoe woorden met elkaar in verband staan, hoe ideeën worden geformuleerd en zelfs hoe mensen emoties of meningen uiten. Zie het trainen van een LLM als het onderwijzen van een student die bijna elk artikel op internet heeft gelezen, maar in plaats van specifieke zinnen te onthouden, onthouden ze hoe die zinnen samenwerken.

Elke keer dat je een LLM een vraag stelt, zoekt het niet het antwoord op. In plaats daarvan voorspelt het welke woorden of ideeën er vervolgens moeten komen op basis van alles wat het heeft geleerd. Deze voorspellende magie vormt de kern van hoe reacties coherent, inzichtelijk en verrassend menselijk aanvoelen.

Het geheime recept: tokens, context en waarschijnlijkheid

Stel je voor dat je iemands zin afmaakt: “De lucht is…” De kans is groot dat je “blauw” zegt. Dat is een voorspelling. LLMs doen dit, maar op een schaal die je je nauwelijks kunt voorstellen.

Ze zien tekst niet als woorden, maar als tokens, kleine fragmenten die alles vertegenwoordigen, van letters en lettergrepen tot hele woorden. Wanneer je een AI vraagt om “uit te leggen hoe fotosynthese werkt”, splitst deze dit op in tokens en berekent welke token (of woord) vervolgens in het antwoord moet komen door waarschijnlijkheidspatronen te beoordelen.

De berekening is niet willekeurig, maar statistische kunst. Het model bekijkt miljarden signalen die het uit trainingsgegevens heeft geabsorbeerd en voorspelt het volgende token met verbazingwekkende nauwkeurigheid. Wat je terugkrijgt is geen mechanische herhaling, maar een originele reconstructie van betekenis, afgeleid van waarschijnlijkheid en aangeleerde associaties.

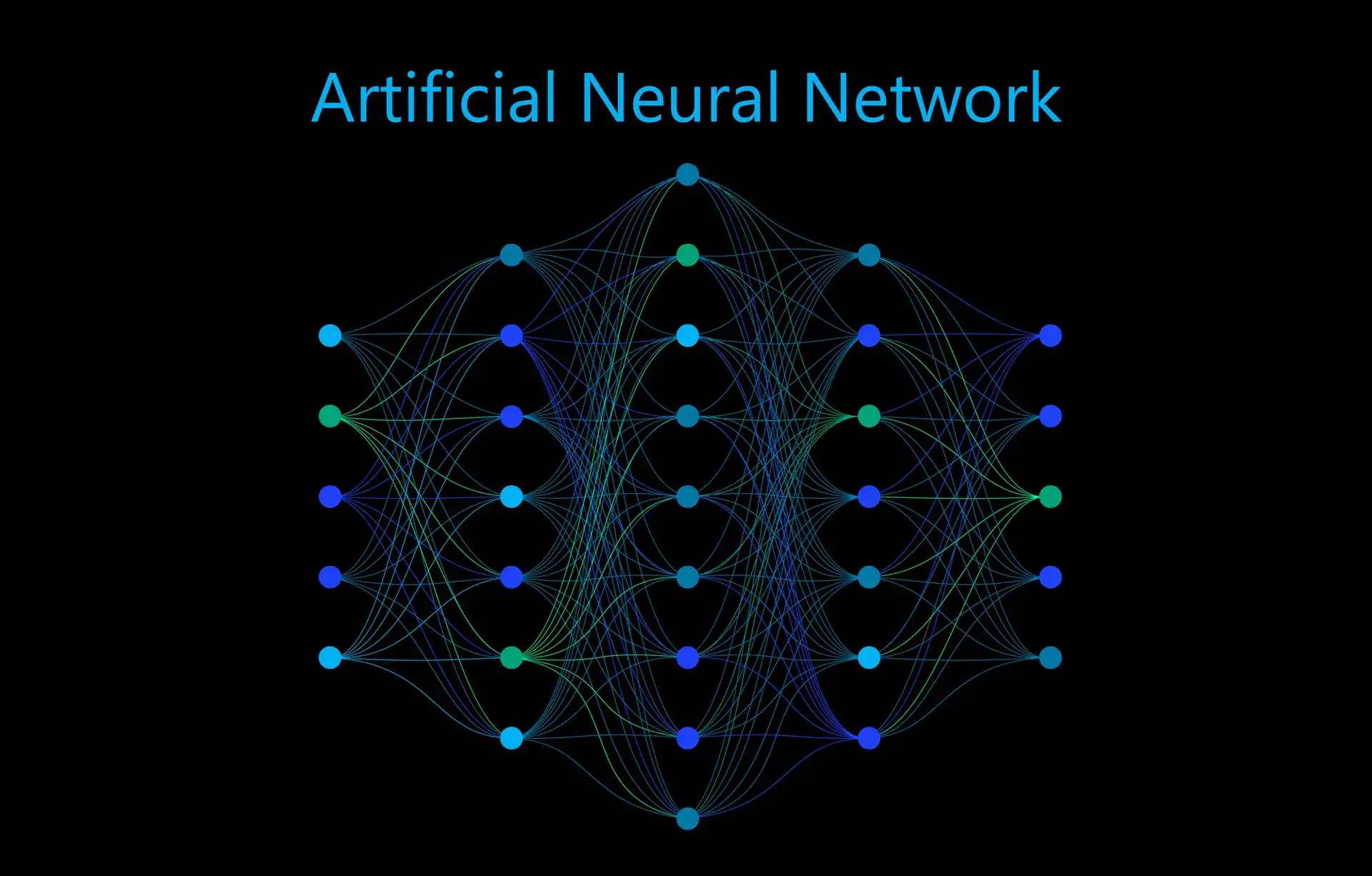

De neurale krachtcentrale: waar AI zijn intuïtie vandaan haalt

U heeft waarschijnlijk wel eens de term ‘transformatormodel’ gehoord. Dit is geen sciencefiction, maar de architecturale ruggengraat van de krachtigste LLM’s van dit moment.

Transformers zijn ontworpen om de context van zowel korte als lange stukken tekst te begrijpen. In tegenstelling tot oudere AI-modellen die informatie alleen sequentieel konden verwerken, kunnen transformers alle woorden in een zin tegelijkertijd analyseren en vaststellen hoe deze zich tot elkaar verhouden. Dankzij dit ‘aandachtsmechanisme’ kan het model bepalen welke woorden het belangrijkst zijn voor de betekenis van de hele boodschap.

In de zin ‘De CEO vertelde de manager dat zij de deal zou goedkeuren’ gebruikt het model bijvoorbeeld de context om te achterhalen naar wie ‘zij’ verwijst. Het is dit vermogen om nuances en relaties te begrijpen dat AI op basis van transformers intuïtief en natuurlijk doet aanvoelen.

Training op het internet: een tweesnijdend zwaard

Het trainen van grote taalmodellen vereist enorme hoeveelheden data en rekenkracht. Het is alsof je een superbrein voedt met alles wat ooit is geschreven en het vervolgens leert om een goed beoordelingsvermogen te ontwikkelen.

De data is afkomstig uit boeken, open forums, artikelen, onderzoeksrapporten en zelfs delen van code. Hoewel dit het model ongelooflijk veelzijdig maakt, brengt het ook uitdagingen, vooringenomenheid, verouderde informatie en feitelijke onnauwkeurigheden met zich mee. Moderne LLM-ontwikkelaars steken enorm veel energie in het verfijnen van de modellen met zorgvuldig samengestelde datasets, begeleide feedback en reinforcement learning om hun antwoorden betrouwbaar en ethisch verantwoord te maken.

Wanneer OpenAI, Google of Anthropic nieuwe modellen trainen, doorlopen ze vaak meerdere fasen van ‘alignment’, een proces waarbij menselijke experts antwoorden beoordelen en het model leren wat gepast, nauwkeurig en waardevol is. Dus ja, er is een zeer menselijke touch die bepaalt hoe AI leert praten.

Achter elke reactie: berekeningen in actie

Laten we eens bekijken wat er gebeurt als je een vraag stelt als: “Wat is de toekomst van energie?”

Eerst worden uw woorden omgezet in tokens. Het model leest die tokens en verwerkt ze via miljoenen (soms miljarden) parameters, kleine verstelbare “knopjes” in het neurale netwerk die aangeleerde taalkenmerken vertegenwoordigen. Vervolgens voorspelt het model waarschijnlijke antwoorden voor de volgende paar tokens en verfijnt deze woord voor woord totdat het antwoord compleet aanvoelt.

Wat er gebeurt, is een symfonie van matrixvermenigvuldigingen, een wiskundig orkest dat razendsnel speelt in verafgelegen datacenters. Elke laag van het neurale netwerk verfijnt de betekenis, toon en relevantie, zodat wat je ziet samenhangend en doordacht aanvoelt.

En omdat het model niet lineair “denkt” zoals mensen dat doen, kan het verbanden leggen die wij misschien niet meteen zouden leggen, door inzichten uit meerdere disciplines bijna moeiteloos te combineren.

Waarom LLM’s zo menselijk aanvoelen

De magie van een gesprek ligt in empathie en ritme. Verrassend genoeg hebben LLM’s dit geleerd, maar niet door emotie, maar door blootstelling.

Wanneer ze worden getraind op miljarden gespreksfragmenten, leren ze de eb en vloed van menselijke dialogen: de pauzes, bevestigingen en enthousiaste tonen die tekst levendig maken. Wanneer een gebruiker bijvoorbeeld zegt: “Ik loop vast met mijn start-upidee”, reageert het model niet alleen met logica, maar biedt het vaak ook aanmoediging, waarbij het motiverende taal gebruikt die het heeft geleerd uit realistische menselijke interacties.

Deze emotionele resonantie is niet bewust, maar zorgt ervoor dat samenwerking met AI natuurlijk aanvoelt. Bedrijfsleiders, contentmakers en docenten vinden deze eigenschap van onschatbare waarde bij het integreren van AI-schrijf- of ondersteuningstools in hun workflows.

Business Meets the Machine: Real-World LLM Impact

Nu u een glimp hebt opgevangen van de werking, laten we het hebben over de waarde. Hoe transformeren deze modellen het bedrijfsleven, creativiteit en innovatie?

Denk aan sectoren als klantervaring, marketingautomatisering of data-analyse. LLM’s vormen de basis voor chatbots die 24/7 met empathie en precisie met klanten kunnen communiceren. Ze herschrijven blogontwerpen, analyseren SEO-gegevens, genereren codefragmenten en vatten zelfs complexe onderzoeken samen, en dat alles in recordtijd.

Voor professionals die dagelijks duizend taken moeten combineren, is AI niet alleen een assistent, maar ook een strategische versterker. Wat vroeger uren brainstormen, ontwerpen of reviseren kostte, kan nu in enkele minuten worden bereikt, waardoor teams meer ruimte hebben om te innoveren, ideeën te bedenken en te groeien.

Tools zoals Jasper.ai, DeepSeek AI en Fireflies.ai geven productiviteit een nieuwe vorm. AI-vergaderassistenten vatten discussies samen. Copygenerators stellen advertentiecampagnes op. Ontwikkelaars gebruiken op LLM gebaseerde copiloten om in realtime te debuggen en te optimaliseren. Achter al deze mogelijkheden schuilt hetzelfde kernprincipe: tokenized prediction, aangedreven door een op mensen afgestemd ontwerp.

Hersenen en verbeeldingskracht: de dubbele kracht van LLM’s

Hier is een leuke paradox: LLM’s zijn op hun best wanneer ze precisie en verbeeldingskracht in evenwicht brengen. Vraag ze om productbeschrijvingen te schrijven en ze leveren gepolijste teksten. Vraag ze om frisse creatieve ideeën en ze bedenken iets dat tot nadenken stemt.Maar vraag ze om harde feiten of het laatste nieuws, en ze kunnen in de problemen komen.

Waarom? Omdat LLM’s niet in realtime ‘weten’. Ze vertrouwen op wat ze hebben geleerd, niet op een live feed met wereldwijde updates. Daarom levert het combineren van LLM’s met verbonden datatools zoals API’s, realtime databases en zoeksystemen nog krachtigere resultaten op.

Wanneer bedrijven gebruikmaken van AI-automatisering, is menselijk toezicht dus het geheime ingrediënt. AI stelt voor, mensen sturen bij. Het is deze samenwerking die echt betekenisvolle innovatie creëert.

Meer dan alleen tekstgeneratie: de opkomst van redenerende AI

We staan nog maar aan het begin. De volgende generatie LLM’s gaat niet alleen over het genereren van tekst, maar ook over het begrijpen van context, het redeneren op basis van verschillende bronnen en het leggen van logische verbanden. Deze opkomende modellen, vaak ‘LLM 2.0’ of ‘redeneringsengines’ genoemd, combineren geheugen, symbolische logica en meerstaps redeneringsvermogen om rijkere antwoorden te geven.

Stel je voor dat je je AI-assistent vraagt: “Vat de vijf belangrijkste trends op het gebied van AI-ethiek van de afgelopen zes maanden samen.” Binnenkort zou deze, in plaats van statische samenvattingen te geven, geverifieerde publicaties kunnen scannen, perspectieven kunnen afwegen en beknopte, onderbouwde inzichten kunnen leveren – net als een onderzoeksanalist.

Dat is de toekomst waar bedrijfsleiders zich op voorbereiden. Een wereld waarin taalmodellen meer als partners dan als tools denken.

Waar data en verbeelding samenkomen: de belofte van de toekomst van AI

Als we een kijkje nemen achter de schermen van LLM’s, wordt één ding duidelijk: ze herdefiniëren niet alleen hoe machines praten, maar ook hoe mensen werken, denken en creëren. De verborgen wiskunde, de tokens, de training, alles komt samen in één simpele goocheltruc: data omzetten in dialoog.

Dus de volgende keer dat een AI-assistent uw vraag beantwoordt of u helpt bij het schrijven van een voorstel, neem dan even de tijd om de technische prestatie achter die vriendelijke toon te waarderen. Miljoenen parameters, terabytes aan data en tientallen jaren van onderzoek maken die naadloze uitwisseling mogelijk.

De toekomst van de samenwerking tussen mens en AI is niet koud of mechanisch, maar levendig, creatief en ingrijpend transformatief.

En als u een bedrijfsleider bent die zich afvraagt hoe u hiervan kunt profiteren, dan is dit het beste moment om te experimenteren. Gebruik AI-tools. Integreer ze in uw workflows. Laat ze het zware werk doen, terwijl u zich concentreert op creativiteit en strategie.

Klaar om het ware potentieel van AI voor uw bedrijf te ontsluiten?